这项由延庆大学金胜卓教授团队联合卡内基梅隆大学、NAVER Cloud和Adobe研究院共同完成的研究发表于2025年7月,论文标题为"Multi-Granular Spatio-Temporal Token Merging for Training-Free Acceleration of Video LLMs"。有兴趣深入了解的读者可以通过arXiv:2507.07990访问完整论文。

当我们用ChatGPT这样的AI助手分析一段视频时,背后发生了什么?就像一个人要理解一部电影,需要逐帧观看每个画面一样,AI也需要把视频切分成无数个小片段来分析。但这里有个大问题:视频包含的信息量实在太庞大了。一个一小时的视频可能需要AI处理数万个"小片段"(专业术语叫"token"),这就像让一个人同时记住一万张照片的所有细节一样困难。

更要命的是,处理这些片段的计算量会呈指数级增长。如果有一千个片段需要处理,那么计算量可能达到一千的平方,也就是一百万倍的复杂度。这就好比你要整理一千张照片,不仅要看每张照片,还要把每张照片都和其他所有照片做比较,工作量瞬间爆炸。

现在,研究团队找到了一个巧妙的解决方案,他们开发了一种叫做"多粒度时空token合并"的技术。这个技术的核心思想就像整理家里的物品一样:把相似的东西归类放在一起,没必要每个小物件都单独占用一个柜子。

这项技术的创新之处在于它能够识别视频中的冗余信息。想象你在看一部电影,其中有一个场景是主人公在海边静静地坐着,镜头持续了十秒钟。在这十秒钟里,除了海浪轻微的波动,背景几乎没有变化。传统的AI需要把这十秒钟的每一帧都当作全新的信息来处理,而新技术能够识别出这些帧之间的相似性,将它们合并成一个"超级帧"来处理。

研究团队采用了一个分层处理的策略,就像搭积木一样从粗到细。首先,他们使用一种叫做"四叉树"的数据结构来分析每一帧画面。这个过程就像用放大镜看一幅画:先看整体,如果发现某个区域比较单调(比如一大片蓝天),就用一个粗糙的描述来代表;如果发现某个区域很复杂(比如人物的面部表情),就用更精细的描述来保留细节。

在空间维度上,技术会智能地决定画面的哪些部分需要精细处理,哪些部分可以粗糙处理。就像你在画素描时,重要的部分会画得很细致,而背景可能只用几笔带过。这样既保证了重要信息不丢失,又大大减少了需要处理的数据量。

在时间维度上,技术会比较相邻帧之间的相似性。如果发现连续几帧的某个区域基本没有变化,就会将这些信息合并到最早出现的那一帧中。这就像写日记时,如果连续几天都是同样的天气,你可能会写"这一周都是晴天"而不是每天都重复写一遍"今天晴天"。

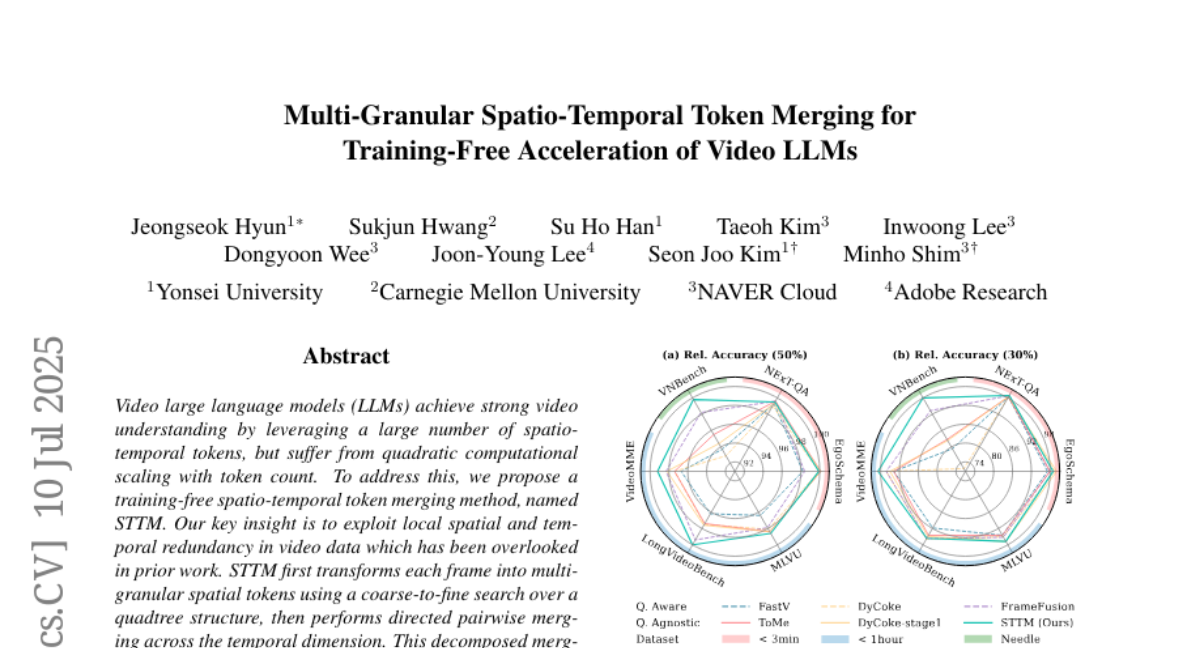

这种合并策略带来了显著的性能提升。在实验中,当AI需要处理的数据量减少到原来的一半时,新技术能够让处理速度提升两倍,而准确率只下降了0.5%。当数据量减少到原来的30%时,速度提升了三倍,准确率也只下降了2%。这就好比你原来需要看一万张照片来理解一个故事,现在只需要看三千张就能理解同样的内容,而且理解的准确度几乎没有下降。

更重要的是,这项技术具有一个独特的优势:它不需要知道用户要问什么问题就能进行优化。传统的方法需要根据具体的问题来决定保留哪些信息,这就像一个图书管理员必须知道读者要找什么书才能整理书架。而新技术能够提前整理好信息,不管用户问什么问题都能快速响应。这种特性使得同一个视频的处理结果可以被重复使用,大大提高了实际应用中的效率。

研究团队在六个不同的视频问答数据集上测试了他们的技术。这些数据集涵盖了各种类型的视频:有短视频(几分钟),有长视频(一小时以上),还有特殊的"大海捞针"类型视频。所谓"大海捞针",就是在很长的视频中隐藏一些微小但重要的信息,测试AI是否能够准确找到这些信息。

在短视频任务中,新技术表现出色,能够准确理解视频内容并回答相关问题。在长视频任务中,技术的优势更加明显,因为长视频中往往包含更多的冗余信息,为合并提供了更大的空间。最令人印象深刻的是在"大海捞针"任务中的表现:当其他方法的准确率大幅下降时,新技术仍能保持相对较高的准确率,这说明它在压缩数据的同时能够很好地保留关键信息。

技术的实现细节也很有趣。在空间合并阶段,系统会计算图像块之间的相似度,如果相似度超过某个阈值,就会将它们合并。这个过程就像玩拼图游戏,当你发现两块拼图的颜色和纹理非常相似时,就知道它们可能属于同一个区域。

在时间合并阶段,系统会跨时间比较相同空间位置的内容。如果发现某个区域在连续几帧中都很相似,就会建立一个"合并链",将后面的帧都合并到最早的帧中。这就像追踪一个物体的运动轨迹,当发现物体在某个时间段内基本静止时,就用一个状态来描述这整个时间段。

研究团队还解决了一个技术难题:如何处理不同精度级别的信息合并。有时候,某个区域在前一帧中用粗糙的描述就够了,但在后一帧中需要精细的描述,或者相反。这就像两个人在描述同一个场景,一个人说"那里有棵树",另一个人说"那里有一棵长满绿叶的大橡树"。系统需要决定如何将这两种不同精度的描述合并起来。

为了解决这个问题,研究团队采用了一种简化的策略:当出现多个可能的合并目标时,系统会选择位置最靠左上角的那个目标。虽然这不是最理想的选择,但它能够保证算法的效率,而且在实际应用中效果很好。

这项技术的另一个创新点是它不需要重新训练AI模型。传统的优化方法通常需要对整个AI系统进行重新训练,这个过程既耗时又昂贵。新技术是一个"即插即用"的模块,可以直接插入现有的AI系统中,就像给电脑安装一个新的软件一样简单。

研究团队还验证了技术在不同规模AI模型上的效果。他们测试了从70亿参数到720亿参数的各种模型,发现新技术在所有规模上都能带来显著的性能提升。这说明技术的适用性很广,不仅适用于小型模型,也适用于大型模型。

在实际部署方面,这项技术特别适合视频聊天机器人这样的应用场景。当用户上传一个视频并想要进行多轮对话时,系统只需要在第一次处理时进行token合并,之后的所有问题都可以基于这个压缩后的表示来快速回答。这就像先把一本厚厚的书整理成一个详细的目录,之后不管读者问什么问题,都能快速找到相关章节。

技术的可视化效果也很有说服力。研究团队展示了合并前后的对比图,可以清楚地看到系统是如何智能地保留重要信息而合并冗余信息的。比如,在一个视频画面中,人物面部被保留了很多细节,而背景的大片天空被合并成了几个大块。这种选择性的处理方式体现了技术的智能性。

从更广泛的角度来看,这项技术解决了当前视频AI面临的一个关键瓶颈。随着视频内容的增长和AI应用的普及,如何高效处理视频数据成为了一个越来越重要的问题。这项技术提供了一个实用的解决方案,既能保证处理质量,又能显著提高处理速度。

值得注意的是,这项技术在不同类型的视频上表现差异很大。对于内容变化较少的视频(比如新闻播报),技术能够实现很高的压缩比而几乎不损失准确性。但对于内容变化很快的视频(比如动作片),压缩比会相对较低,但仍然能够带来显著的性能提升。

研究团队还发现,技术在处理长视频时的优势特别明显。这是因为长视频中通常包含更多的重复内容和冗余信息,为合并提供了更大的空间。这个发现对于未来的视频AI应用具有重要意义,因为用户上传的视频往往越来越长。

技术的另一个优势是它对不同类型的AI模型都有效。研究团队测试了多种主流的视频AI模型,包括LLaVA-Video、LLaVA-OneVision和Qwen2VL等,发现新技术在所有这些模型上都能带来一致的性能提升。这种通用性使得技术的应用前景更加广阔。

从实施角度来看,这项技术的部署相对简单。它不需要对现有的AI系统进行大幅修改,只需要在适当的位置插入合并模块即可。这种设计使得技术能够快速被现有的AI服务提供商采用,加速整个行业的发展。

说到底,这项技术的本质是一种智能的信息压缩方法。它能够在保持信息完整性的同时显著减少计算负担,这对于视频AI的实际应用具有重要价值。随着视频内容的爆炸式增长和AI应用的普及,这类技术将变得越来越重要。

归根结底,这项研究展示了如何通过智能算法设计来解决实际工程问题。它不仅提供了一个具体的解决方案,还为未来的相关研究提供了有价值的思路。对于普通用户来说,这意味着未来的视频AI应用会变得更快、更便宜,同时保持高质量的服务。这种技术进步最终会惠及每一个使用AI产品的人,让我们能够更好地利用人工智能来理解和处理视频内容。

Q&A

Q1:这个新技术具体是怎么让AI处理视频变快的? A:就像整理房间一样,技术把视频中相似的画面和重复的内容"打包"在一起处理,而不是每个细节都单独分析。比如一段十秒钟的海滩静景,传统方法要分析300帧画面,新技术可能只需要分析几十帧就够了,自然就快了。

Q2:这种加速会不会影响AI理解视频的准确性? A:影响很小。实验显示,即使处理速度提升2-3倍,准确率也只下降0.5-2%。这就像看电影时跳过一些重复镜头,你仍然能完整理解故事情节。关键信息都被保留了,只是去掉了冗余内容。

Q3:普通人能用到这项技术吗?什么时候能用上? A:这项技术主要面向AI开发者和服务提供商,普通用户不需要直接使用。但当视频AI应用(如视频聊天机器人、视频内容分析工具)采用这项技术后,用户就能享受到更快的响应速度和更低的使用成本。

配查查-股市如何配资-配资资深股票配资门户-配资网网站提示:文章来自网络,不代表本站观点。